Если вы хотите использовать веб-данные, то вы попали по адресу. Вот тщательно подобранный список лучших инструментов и программного обеспечения для парсинга веб-страниц.

Что такое веб-скрапинг?

Веб-скрапинг – это процесс извлечения данных с веб-сайта. Очистка веб-страниц может выполняться как вручную пользователем, так и с помощью инструмента автоматизации, реализованного с помощью бота или веб-сканера.

Что – это инструмент для парсинга веб-страниц

Инструменты веб-сбора также известны как инструменты веб-сбора или инструменты извлечения веб-данных. Веб-скраперы используют интеллектуальную автоматизацию для извлечения полезной информации с веб-сайтов. Эти инструменты помогут вам беспрепятственно собирать огромные данные с веб-сайтов в больших масштабах. Эти инструменты позволяют нам загружать данные в форме Excel, CSV или XML.

Типы Инструменты очистки экрана

На рынке доступны следующие типы инструментов веб-скрапинга:

- Расширение для браузера

- Устанавливаемое программное обеспечение

- Облачное программное обеспечение

Лучшие инструменты веб-скрапера

Вот список лучших инструментов веб-скрапера для сбора и анализа данных с популярными функциями и новейшими ссылка для скачивания.

Изучите детали, прежде чем покупать что-либо для своих нужд. Инструменты веб-скрапинга, как платные, так и с открытым исходным кодом, могут быть хорошим выбором

#1. Яркие данные

Браузер для парсинга Bright Data — это мощный браузер для парсинга веб-данных, который обеспечивает легкий доступ к целевым веб-сайтам и позволяет извлекать соответствующие данные.

Он автоматизирует все операции разблокировки веб-сайтов, включая решение CAPTCHA. , снятие отпечатков пальцев браузера и многое другое.

С помощью API Puppeteer (Python) или Playwright (Node.js) вы можете получать любое количество сеансов браузера и беспрепятственно взаимодействовать с ними.

Браузер Scraping размещается в инфраструктуре Bright Data, что делает его масштабируемым и экономичным. Он также использует технологию искусственного интеллекта для обхода программного обеспечения для обнаружения ботов, перехитрив любую систему обнаружения ботов.

В отличие от безголовых браузеров, Scraping Browser представляет собой графический интерфейс/браузер с меньшей вероятностью быть обнаруженным программным обеспечением для обнаружения ботов.< /p>

- Цена:От 15 долларов США за ГБ.

- Пробная версия: бесплатная 7-дневная пробная версия.

- Поддержка: чат, телефон и электронная почта.

Bright Data

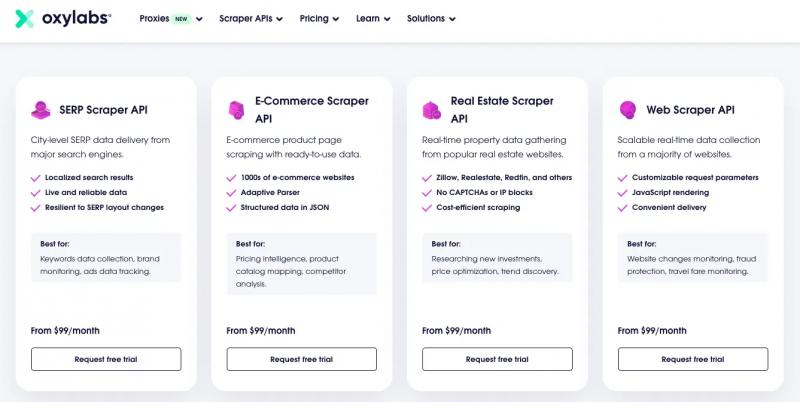

#2. API-парсеры Oxylabs

API-интерфейсы Scraper от Oxylabs могут извлекать общедоступные веб-данные даже с самых сложных страниц. Лучше всего подходит для крупномасштабных операций по парсингу веб-страниц. Существует четыре API-интерфейса парсера: API парсера SERP, API парсера электронной коммерции, API парсера недвижимости и API веб-скребка. Каждый API-интерфейс Scraper специально создан для различных целей, чтобы улучшить общую производительность и удобство использования. От 99 долларов США в месяц.

Функции:

- Все API-интерфейсы Scraper гарантируют:

- оплату только за успешные результаты;

- легкий доступ к локализованному контенту;

- Легкое масштабирование для ваших растущих потребностей;

- более 102 миллионов прокси-пулов;

- Доставка данных в ваше облачное хранилище (AWS S3 или GCS);

- Легкий обход географических ограничений с заметно меньшим количеством CAPTCHA или IP-блокировок

- 24/7 поддержка через чат и электронную почту

- 7-дневная бесплатная пробная версия с без комментариев. Кредитная карта не требуется.

Цены:

- Бесплатно: 5 тыс. страниц, 5 результатов/с

- Начальный план: 99 долларов США в месяц — 29 тысяч страниц, 15 результатов в секунду.

- Бизнес-план: 399 долларов США в месяц — 160 тысяч страниц, 50 результатов в секунду.

- Корпоративный план: 999 долларов США в месяц — 526 тысяч страниц, 100 результатов в секунду.< /ul>СКИДКА 35% на Oxylabs

#3. API-скребок

Scraper API — это прокси-API для веб-скрапинга; Он обрабатывает прокси-серверы, браузеры и CAPTCHA, поэтому вы можете получить HTML-код с любой веб-страницы с помощью простого вызова API.

Вы никогда не будете заблокированы, поскольку с каждым запросом он меняет IP-адреса из пула миллионов прокси-серверов. более десятка интернет-провайдеров и автоматически повторяет неудачные запросы, а также решает за вас капчу.

Scraper API прост в использовании и полностью настраиваемый; он позволяет вам настраивать заголовки запросов, тип запроса, геолокацию IP и многое другое практически без усилий.

Используйте купон «STM10» со скидкой 10 %. Нажмите здесь, чтобы купить сейчас.Особенности:

- У них более 40+ миллионов IP-адресов по всему миру. .

- Вы можете настроить таргетинг на более чем 12 геолокаций.

- Простая автоматизация позволяет автоматизировать все сложные задачи, такие как автоматизация ротации IP-адресов, обработка CAPTCHA, рендеринг JavaScript с помощью автономных браузеров и многое другое.

- Гарантия безотказной работы 99,9 % с неограниченной пропускной способностью. и профессиональная поддержка.

- Неограниченная пропускная способность; Каждый используемый API-парсер прокси обеспечивает неограниченную пропускную способность, а это означает, что с вас взимается плата только за успешные запросы.

- Сверхбыстрая поддержка; Scraper API имеет репутацию быстрой и профессиональной поддержки.

Используйте купон «STM10» для получения скидки 10 %. Нажмите здесь, чтобы купить сейчас

Цены:

Scraper API прекрасно сочетается с популярными языками программирования, такими как Bash, Node, Python, Scrapy, PHP, Ruby. Если вы не уверены в покупке API-скребка, вы можете создать бесплатную пробную учетную запись, чтобы опробовать его. Попробуйте и посмотрите, как пойдет. Вы можете обновить его в любое время.

Scraper API

#4. Octoparse

Octoparse – это бесплатный инструмент для очистки веб-страниц. Он позволяет извлекать данные с веб-сайтов без программирования и превращать веб-страницы в структурированные данные за несколько кликов.

Функции:

- Соскребите все данные простым наведением и щелчком мыши. Кодирование не требуется.

- Автоматическая ротация IP-адресов для предотвращения блокировки IP-адресов.

- Запланируйте выполнение задач для очистки в любое определенное время, ежечасно, ежедневно, еженедельно…

- Сбор веб-сайтов с бесконечной прокруткой, входом в систему, раскрывающимся списком, AJAX…

- Загружайте очищенные данные в формате CSV, Excel, API или сохраняйте в базах данных.

Основано: 2012 г.

Расположение: США ШтатыЦены:Его бесплатный план идеально подходит для простых проектов. С помощью бесплатного плана вы можете сканировать неограниченное количество страниц и допускаете 2 одновременных локальных запуска и 10 сканеров.

Стандартный план стоит 75 долларов США в месяц. У него также есть 2 разных плана:

- Стандартный план за 75 долларов США в месяц

- Профессиональный план за 209 долларов США в месяц

Он также предлагает корпоративный план в соответствии с вашими требованиями. Octoparse

#5. Парсинг-бот

Scraping Bot предлагает мощный API для очистки веб-страниц для извлечения HTML-контента без блокировки. Конкретные API для сбора данных: розничная торговля (для получения описания продукта, цены, валюты), недвижимость (для сбора сведений об объекте недвижимости, таких как цена покупки или аренды, площадь, местоположение) и т. д.

Функции :

- Простой в интеграции API-интерфейс

- Доступные ценовые планы

- JS-рендеринг – очистка с помощью headless-браузеров веб-сайтов в Angular JS, Ajax,

- JS, React JS, и многое другое.

- Управление прокси-серверами и браузерами

- Геотаргетинг

Ссылка на веб-сайт: ScrapingBot

Цены: Стоимость начинается от 39 евро в месяц. У него также есть 3 различных плана:

- Фрилансер — 39 евро в месяц.

- Стартап — 99 евро в месяц.

- Бизнес — 299 евро в месяц.

- Предприятие — 699 евро в месяц< /ul>

Scraper Bot также предлагает бесплатный план с ограниченными функциями и индивидуальными планами в соответствии с вашими требованиями. ScrapingBot

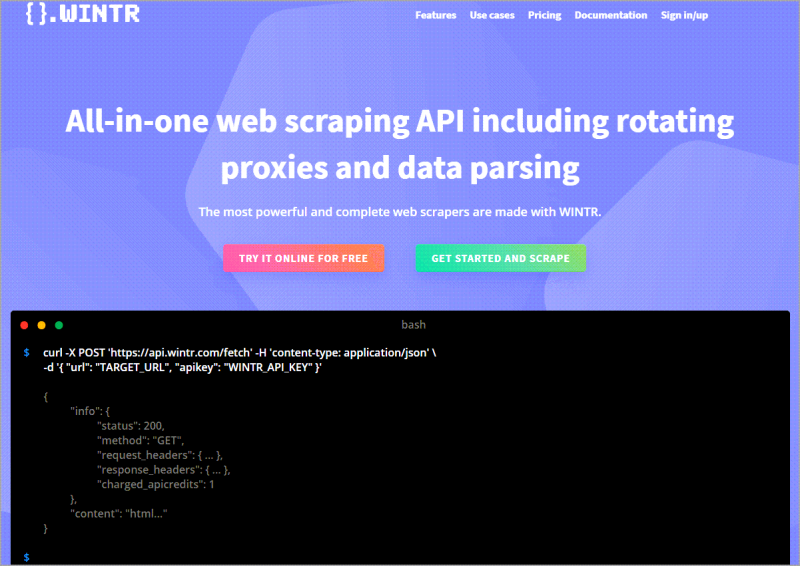

#6. Зима

Wintr — это API веб-скрапинга с использованием меняющихся резидентных прокси, позволяющий собирать и анализировать любые данные, доступные в Интернете.

Простой в использовании и полностью настраиваемый, WINTR имеет множество инструментов для сбора данных даже с самых сложных веб-сайтов. Например, вы можете легко очистить содержимое общедоступной веб-страницы, используя меняющийся IP-адрес, или автоматизировать аутентификацию с помощью рендеринга Javascript, а затем очистить личные данные, используя файлы cookie сеанса и постоянный IP-адрес.

Очистка необработанного HTML — это круто, но требует от вас определенных усилий. проанализировать его и получить необходимые данные. WINTR предлагает более эффективный подход к сбору данных, возвращая в ответе объект JSON, содержащий структурированные данные. Чтобы воспользоваться этой функцией, перед вызовом API необходимо определить схему вывода JSON.

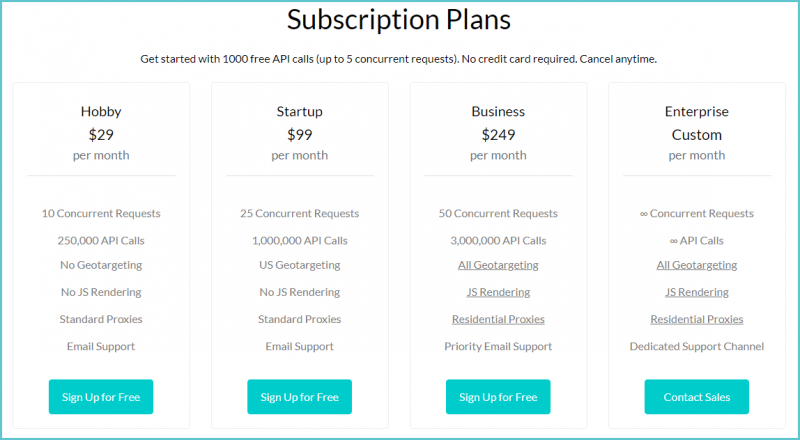

Цены: Цены начинаются с 20 евро в месяц. У него также есть 6 различных планов:

- Бронзовый за 20 евро в месяц.

- Серебро — 40 евро в месяц.

- Золото — 80 евро в месяц.

- Платина — 150 евро в месяц.

- Бриллиант — 150 евро в месяц.

- Плата по мере использования — от 500 евро в месяц.

- Смена прокси – Наслаждайтесь обширным пулом прокси, который гарантирует, что вы всегда будете в скрытом режиме.

- Обход Anti-Bot – Парсеры ZenRows автоматически обходят все основные меры защиты от ботов.

- Извлечение данных – точно настроенный алгоритм автоанализа, который автоматически извлекает данные для вас.

- Визуализация Javascript – Быстро визуализируйте любой веб-сайт, который в значительной степени использует Javascript.

- Резидентные прокси – просматривайте как реальный пользователь с лучшими домашними и мобильными прокси-серверами 4G.

- Неограниченный масштаб – Начните с малого и станьте большим. Работайте в Интернете с неограниченной пропускной способностью.

- Разработчик – 49 долларов США в месяц

- Стартап – 99 долларов США в месяц

- Бизнес – 249 долларов США в месяц

- Предприятие – $999+/месяц (индивидуальный план)

- Автоматическая ротация прокси исключает возможность блокировки IP-адресов и обеспечивает плавный и бесперебойный сбор данных. Попрощайтесь с заблокированными IP-адресами и CAPTCHA.

- Геотаргетинг по всему мирупозволяет пользователям получать доступ к веб-страницам из разных мест по всему миру, что позволяет им извлекать географически специфичную информацию.

- Рендеринг Javascript помогает собирать данные с веб-сайтов с помощью React, AngularJS, Ajax, Vue.js, или другие библиотеки.

- Простой в интеграции API обеспечивает плавную интеграцию с любой платформой или системой.

- Использование пользовательских файлов cookie позволяет пользователям вводить свои собственные файлы cookie для использоваться при парсинге нужного веб-сайта, обеспечивая более персонализированный и целенаправленный парсинг.

- Выполнение JavaScriptФункция позволяет пользователям выполнять код JavaScript на целевом веб-сайте для извлечения определенных данных.

- Индивидуальный — 30 долларов США в месяц.

- Стартовый — 45 долларов США в месяц.

- Бизнес — 90 долларов США в месяц.

- Корпоративный — 200 долларов США в месяц.

- Сбор разрозненных данных

- Извлечение документов

- Извлечение адреса электронной почты

- Извлечение IP-адреса

- Извлечение изображений

- Извлечение номера телефона

- Извлечение цен

- Извлечение веб-данных

- Выпуск для сообщества: бесплатно (Выпуск для сообщества) используется более чем 600 000 исследователей данных и идеально подходит для проектов и экспериментов)

- Редакция Enterprise: Контактный отдел продаж

- широкий глобальный охват

- машино- Читабельность

- Структурирование данных. Организуйте извлеченные данные в легко усваиваемую структуру.

- графический интерфейс на основе браузера.

- Нажмите, чтобы извлечь текст, изображения, атрибуты и многое другое.

- Очистите данные с любого динамического веб-сайта.

- Извлеките загружаемый контент с помощью AJAX и JavaScript.

- Очистите и сохраните данные на наших серверах.

- Подключитесь к нашему REST API или загрузите файл CSV/Excel

- Соберите миллионы точек данных за считанные минуты

- Экономьте время на копирование и вставку. Никогда больше не пишите код

- Стандартный план за 149 долларов США в месяц.

- Профессиональный план за 499 долларов США в месяц.

- сбор разрозненных данных

- извлечение документов

- извлечение адресов электронной почты

- Извлечение IP-адреса

- Извлечение изображения

- Извлечение номера телефона

- Извлечение цен

- Извлечение веб-данных

- Проектный план — 250 долларов США в месяц.

- Профессиональный план — 350 долларов США в месяц.

- План «Корпоративный» — 450 долларов США в месяц.

- Стартовый за 299 долларов в месяц.

- Плюс за 899 долларов в месяц.

- Генерация URL-адресов

- Уведомления по электронной почте

- Управление нумерацией страниц – позволяет извлекать данные с нескольких страниц

- Вы можете написать свои собственные правила извлечения, используя XPath, CSS и, Селекторы регулярных выражений

- Базовый план начинается от 40 долларов США в месяц за 5000 страниц.

- Автоматическое сканирование веб-сайтов с разбивкой на страницы.

- Очистка одностраничного или многостраничного сканирования и очистки.

- Автоматический переход на следующую страницу.

- Извлечение электронных писем с помощью RegEx (регулярные выражения)

- Загрузка очистки изображений

- Загрузка готовых страниц с очисткой изображений< li>Поддержка международных языков с помощью UTF-8

- Заполнение форм с использованием данных Xls и очистка

- Индивидуальный — 19,99 долларов США в месяц.

- Малый бизнес — 49 долларов США в месяц.

- Бизнес — 99 долларов США в месяц.

- Бизнес-план — 200 долларов США в месяц.

ul>

Wintr также предлагает бесплатный план с ограниченными функциями и индивидуальные планы в соответствии с вашими требованиями. Wintr

#7. ZenRows

Zenrows – это инструмент для очистки веб-страниц, который упрощает работу с прокси-серверами, браузерами, а также CAPTCHA. Этот инструмент предоставляет HTML-данные любой веб-страницы за один вызов API.

Возможности:

Цены: ZenRows предлагает пользователям 4 платных плана, из которых 3 можно попробовать бесплатно.

#8. Scrape-It.Cloud

Scrape-It.Cloud — это прокси-API для парсинга веб-страниц, который позволяет эффективно и без усилий собирать данные. Его большой пул прокси-серверов предоставляет пользователям пропускную способность, позволяющую обойти ограничение скорости на любом веб-сайте, снижая вероятность блокировки и надежно скрывая парсинг-ботов. Scrape-It.Cloud поддерживает автономные браузеры и вращающиеся прокси-серверы, избавляя пользователей от необходимости настраивать какую-либо техническую инфраструктуру или управлять сложными интеграциями API. Кроме того, Scrape-It.Cloud предлагает готовые парсеры для популярных сервисов, таких как Google, Amazon, Yelp, Zillow и других.

Возможности:

Цены: Цены начинаются от 30 долларов США в месяц. У него также есть 4 различных плана:

Scrape-It.Cloud

#9. Импорт.io

Import.io — это платформа интеграции веб-данных SaaS, которая позволяет людям преобразовывать полуструктурированные веб-данные на веб-страницах в структурированные данные. Он обеспечивает извлечение данных в реальном времени с помощью наших API-интерфейсов на основе JSON REST и потоковых API, а также интегрируется со многими языками программирования и инструментами анализа данных.

Функции:

< strong>Основано: 2012 г.

Расположение:США

Ссылка на веб-сайт: Import.io

Цены: Содержит версии для сообщества и предприятия.#10. Webhose.io

Webhose.io – это расширенный API-сервис для сканирования данных, который специализируется на предоставлении доступа к структурированным данным из миллионов веб-источников.

Функции:

Основано: 2007 г.

Расположение: Израиль

< strong>Ссылка на веб-сайт: Webhose

Цены: Webhose.io предоставляет бесплатную пробную версию. Чтобы узнать цену, свяжитесь с их отделом продаж.#11. Scrapinghub

Scrapinghub специализируется на быстром и эффективном извлечении данных с использованием технологий с открытым исходным кодом. Инструмент обрабатывает более 3 миллиардов веб-страниц в месяц. Он имеет четыре различных типа инструментов — Crawlera, AutoExtract, Scrapy Cloud и Splash. Он предоставляет разные веб-услуги для разных людей.

Основано: 2010 г.

Расположено: Ирландия

Ссылка на веб-сайт: ScrapingHub

Цены: Scrapinghub предлагает бесплатную пробную версию.№ 12. Dexi Intelligent (ранее известный как CloudScrape)

Dexi собирает структурированные данные с любого веб-сайта, API и баз данных и не требует загрузки. Его программное обеспечение для извлечения, мониторинга и обработки данных обеспечивает быстрые и точные данные. Он позволяет сохранять собранные данные на облачных платформах, таких как Google Drive и Box.net, или экспортировать их в формате CSV или JSON.

Основано: 2015 г.

Расположение: Дания

Ссылка на веб-сайт: Dexi Intelligent

Цены:Dexi.io предлагает бесплатную пробную версию.#13. ParseHub

ParseHub – бесплатный инструмент для очистки веб-страниц. Вы можете превратить любой сайт в электронную таблицу или API, просто щелкнув данные, которые вы хотите извлечь.

Функции:

Основано: 2013 г.

Расположение: Канада

Ссылка на веб-сайт: ParseHub

Цены. Стоимость начинается от 149 долларов США в месяц. У него также есть 2 разных плана:ParseHub также предлагает бесплатный план с ограниченными функциями и корпоративные планы в соответствии с вашими требованиями.

#14. Mozenda

Mozenda — это корпоративное программное обеспечение для парсинга веб-страниц, предназначенное для всех видов извлечения данных. Mozenda доверяют тысячи компаний и более 30 % компаний из списка Global Fortune 500.

Функции:

Основано: 2007 г.

Расположение: США

Ссылка на веб-сайт: Mozenda

Цены: Стоимость начинается от 250 долларов США в месяц. У него также есть 2 разных плана:Mozenda также предлагает индивидуальный план в соответствии с вашими требованиями.

#15. Диффбот

Diffbot автоматизирует извлечение веб-данных с любого веб-сайта с помощью искусственного интеллекта, компьютерного зрения и машинного обучения.

Располагается: США

Ссылка на веб-сайт:Diffbot strong> Diffbot

Цены: Стоимость начинается от 299 долларов США в месяц. У него также есть 2 разных плана:Diffbot также предлагает бесплатную пробную версию с ограниченными функциями и корпоративные планы в соответствии с вашими предпочтениями. требование.

№ 16. ProWebScraper

ProWebScraper – это облачный инструмент для очистки веб-страниц, который позволяет извлекать данные с любого веб-сайта в форматах JSON, CSV, Excel или XML.

< Strong>Функции:

Ссылка на веб-сайт: Prowebscraper

Цены:Стоимость начинается от 40 долларов в месяц. У него также есть 2 разных плана:

ProWebScraper предлагает бесплатную пробную версию с ограниченными функциями.

#17. Data Scraper – простое веб-скрапинг (расширение Web Scraper Chrome)

Data Scraper извлекает данные из веб-страниц HTML и импортирует их в таблицы Microsoft Excel

Функции :

Расположение: США

Ссылка на веб-сайт: Сборщик данных — простой сбор данных из ИнтернетаЦены:Цены начинаются от $ 19,99 в месяц. У него также есть 4 различных плана:

Расширение Web Scraper для Chrome также предлагает бесплатный план, который очищает 500 страниц в месяц.

Другие программные инструменты для очистки веб-страниц:

#18. FMiner

Ссылка на веб-сайт: FMiner

#19. Outwit

Ссылка на веб-сайт: Outwit

#20. Потоковая передача данных

Ссылка на веб-сайт: Потоковая передача данных

#21. Apify SDK

Ссылка на веб-сайт: Apify SDK

#22. Средство захвата контента

Ссылка на веб-сайт: Средство захвата контента

#23. Visual Web Ripper

Ссылка на веб-сайт: Visual Web Ripper

#24. Web Harvey

Ссылка на веб-сайт: Web Harvey

№ 25. PySpider

Ссылка на веб-сайт: PySpider

#26. Кимура

Ссылка на веб-сайт: Кимура

#27. Cheerio

Ссылка на веб-сайт: Cheerio

#28. NodeCrawler

Ссылка на веб-сайт: NodeCrawler

#29. Кукольник

Ссылка на веб-сайт: Кукольник

#30. Драматург

Ссылка на веб-сайт: Драматург

#31. PJscrape

Ссылка на веб-сайт: PJscrape

Мы пропустили ваш любимый инструмент для парсинга веб-страниц? Или вы пробовали какое-либо из наших предложений по выбору лучшего программного обеспечения для парсинга веб-страниц? Дайте нам знать в комментариях.

Находясь там, вы также можете оставить нам предложения о том, какие еще инструменты веб-скрапинга необходимо добавить в список, чтобы эта статья стала идеальной.

FAQ –

Какой инструмент лучше всего подходит для парсинга веб-страниц?

Для парсинга веб-страниц доступно множество инструментов. Выбор лучшего инструмента зависит от ваших конкретных потребностей и предпочтений. Некоторые популярные инструменты включают Scraper API, API-интерфейсы Oxylabs Scraper, Octoparse, Scraping-Bot, Wintr и ZenRows. Каждый из этих инструментов имеет свои уникальные особенности и преимущества.

Как выбрать лучший инструмент для очистки веб-страниц?

При выборе инструмента для парсинга важно учитывать такие факторы, как цена, простота использования, возможности извлечения данных и типы веб-сайтов, которые вы хотите парсить. Также может быть полезно прочитать отзывы опытных пользователей или опробовать несколько разных инструментов, чтобы найти лучший для вас. В конечном счете, «лучшим» является тот, который отвечает вашим потребностям и предоставляет вам необходимые данные определенным образом.

Для чего используется веб-скрапинг?< /h3>

Веб-скрапинг используется для множества различных целей, таких как сбор данных для исследовательских проектов, сбор информации для исследования рынка и даже создание веб-сайтов сравнения цен. Его также можно использовать для мониторинга веб-страниц на предмет изменений и для автоматизации веб-процессов. Веб-скрапинг можно использовать даже для быстрого извлечения больших объемов данных из Интернета. Наконец, среди малого бизнеса становится все более популярным использовать парсинг веб-страниц как эффективный способ мониторинга цен и услуг своих конкурентов. Веб-скрапинг может использоваться в самых разных отраслях, от финансов до путешествий, и может революционизировать способы сбора и анализа данных. При наличии правильных инструментов и методов парсинг веб-страниц может дать бесценную информацию о поведении и тенденциях клиентов.

Заключение

Парсинг веб-сайтов становится все более популярным среди разработчиков, которым необходимо анализировать структуру трафика веб-сайтов. Собирая данные с нескольких веб-сайтов, разработчики могут получить ценную информацию о поведении пользователей, тенденциях и производительности веб-сайта. Эти данные затем можно использовать для оптимизации сайтов для повышения производительности и вовлеченности. Веб-скрапинг также является эффективным способом мониторинга веб-сайтов на предмет изменений или потенциальных угроз и нарушений. Ежедневно собирая эти данные, разработчики могут обеспечить безопасность и актуальность своих веб-сайтов.

В заключение следует отметить, что парсинг веб-страниц – это мощный инструмент, который можно использовать для самых разных целей. От сбора данных для исследовательских проектов до создания веб-сайтов с конкурентоспособными ценами, веб-скрапинг становится все более популярным среди предприятий и разработчиков. При наличии правильных инструментов и методов парсинг веб-страниц может дать бесценную информацию о поведении клиентов, тенденциях и эффективности веб-сайта. Используя веб-скрапинг, компании и разработчики могут получить конкурентное преимущество и создавать инновационные продукты, которые предлагают реальную ценность.

Если вы хотите ознакомиться с нашими последними публикациями, посетите нашу главную страницу.

Нравится этот пост? Не забудьте поделиться им!

Удачного тестирования!

Отказ от ответственности: порядок этих инструментов не предполагает каких-либо рекомендаций.

TAG: qa